Quand on pense « sécurité » sur nos sites web, le lien avec « écologie » semble très lointain voir improbable. Pourtant, le piratage a un coût énergétique réel, non négligeable. Pourquoi cet impact énergétique et comment lutter contre ? Réponses.

Qui sont les pirates, quelles sont leurs cibles ?

Les pirates ont bien évolué durant la dernière décénie. Nous ne parlons plus du cliché d’un ado terré dans sa cave et caché derrière son clavier et ses lunettes, qui trouve le mot de passe de la bibliothèque de son collège et qui peut-être va afficher son pseudonyme sur le site de la boulangerie pour faire le beau auprès de ses copains pirates.

Non, les vrais pirates modernes sont organisés et ne visent pas juste quelques sites spécifiques. Les pirates visent tous les sites. Tout le monde est ciblé. Leur but ? Attaquer partout pour augmenter les chances de « réussite », pour finalement gagner un maximum d’argent avec de la pub, du spam, ou du « phishing » (hameçonnage). Pour y parvenir, aucun scrupule, aucune déontologie bien-sûr. Tous les moyens sont bons.

Mon site est-il vulnérable ?

On l’a vu, tout le monde est ciblé, ce qui signifie que si vous avez un site internet, il y a environ 100% de chances que celui-ci soit attaqué. La question est donc de savoir si votre site est sécurisé ou non.

De manière générale, les sites non entretenus et n’ayant pas eu le soin nécessaire à leur sécurisation sont les plus vulnérables. Mais ce sont surtout les CMS (WordPress, Joomla, Drupal et autres) qui sont visés, car utilisés par le plus grand nombre.

En effet, un CMS, par essence très populaire, va forcément se voir découvrir des failles de sécurité au fil du temps. Un code « parfait », totalement invulnérable « ad vitam aeternam » et à la fois riche en fonctionnalités n’existe pas encore. Dès qu’une interaction avec l’utilisateur ou le visiteur du site est possible, une faille est potentiellement possible.

Ces « failles » ou « vulnérabilités » sont des portes ouvertes involontaires, permise dans le code PHP de votre site, qui permettent un accès non autorisé à des fichiers, des données, ou des fonctionnalités. L’exploitation des failles peut aller de « Permettre d’envoyer du spam » à « Permettre un contrôle total sur les fichiers et la base de données du site ».

Une fois découvertes, ces failles sont généralement rendues publiques pour deux raisons principales : soit pour forcer l’éditeur à sortir le correctif, soit une fois corrigées pour montrer le danger occasionné et inciter les utilisateurs à effectuer les mises à jour. Ces failles sont généralement très rapidement corrigées par les éditeurs de logiciels, mais si le site n’est pas à jour, celui-ci est alors très facilement piratable.

Alors puisque vous êtes sûr d’être attaqués, pour être sûr de ne pas être vulnérable, veillez à ne pas tomber dans l’une des 7 erreurs capitales de sécurité en webmastering.

Mode opératoire des pirates

Le moyen « facile » pour un pirate de prendre le contrôle d’un maximum de sites de manière rapide et automatisée : Développer des programmes qui scrutent tous les sites à la recherche de vulnérabilités connues sur les grands CMS.

Certains pirates commencent souvent par trouver des serveurs web non sécurisés pour y mettre leurs scripts et/ou robots de piratage. Avec plusieurs serveurs, ils se fabriquent ainsi une « machine de guerre » contrôlable à distance. Cet ensemble de serveurs est appelé un « botnet« .

Ils montent ensuite des listes les plus complètes possibles, de tous les sites internet connus, puis des listes de failles connues, puis programment un moyen de tester la présence de ces failles sur un ensemble de sites. Leur botnet envoit ensuite de nombreuses requêtes vers chacun des sites référencés afin d’y trouver une faille leur permettant de prendre le contrôle des sites. Si un site est vulnérable, le pirate peut alors en tirer profit.

Bien-sûr, il y a aussi les attaques par bruteforce, où tous les mots de passe et noms d’utilisateur vont être testés par le robot. Un accès administrateur au site permet également d’en prendre le contrôle.

L’usage qui est fait va du défaçage du site, jusqu’à l’envoi de spams ou le « minage » de crypto-monnaies, en passant bien-sûr par des redirections vers des sites publicitaires, des arnaques, ou la création de pages de « phishing » sur le site.

Finalement, les attaques spécifiquement ciblées sur un site précis sont rares, on observe dans la vaste majorité des cas des attaques de masse qui ciblent plutôt des sites aléatoires, peu importe leur popularité.

Un coût énergétique important

On peut avoir tendance à l’oublier, mais une requête sur un site web demande une certaine puissance de calcul au processeur du serveur et cette puissance de calcul ne va pas sans une puissance électrique : Le serveur consomme une certaine quantité de watts à chaque chargement de page. Cette puissance est plus ou moins importante en fonction de l’optimisation du site.

Or, les tentatives de hack citées ci-dessus ont un point commun : De très nombreuses requêtes inutiles sont envoyées vers les serveurs hébergeant les sites. Cela génère donc une forte utilisation de processeur et donc une forte hausse de consommation électrique.

Un serveur au repos consomme peu d’énergie, notamment grâce aux systèmes d’économie d’énergie fournies par Dell et Intel dans les serveurs que nous utilisons. Mais un processeur en pleine charge consomme une quantité d’électricité non négligeable, l’excédent de consommation pouvant aller de 50 à 300 watts par serveur en fonction de la capacité de celui-ci.

Outre la phase de test de failles et de tentatives de piratages, l’utilisation d’un site piraté peut ensuite demander des ressources énergétiques très importantes également. Le pire des cas étant si le site tente de « miner » des crypto-monnaies.

Bien que cela soit difficilement mesurable, nous estimons que sans aucune action préventive, plus de 75% des requêtes traitées par les serveurs web sont vraisemblablement des tentatives de hack des sites. Une part non négligeable est également utilisée par les moteurs de recherche.

Double peine énergétique

La consommation électrique directe est une chose. Mais dans un datacenter, le local est climatisé pour permettre un bon fonctionnement des serveurs dans un environnement dense (les serveurs sont « rackés » les uns au dessus des autres). Dans un dactacenter, si vous consommez plus d’énergie pour le calcul, vous consommez ensuite plus d’énergie pour le refroidissement.

Bien que notre datacenter de Tours soit climatisé de manière eco-responsable (système de refroidissement par évaporation d’eaux pluviales, demandant une consommation électrique réduite), la plupart des datacenters utilisent un des climatiseurs classiques qui sont très gourmands en énergie. La consommation dûe aux robots est donc très conséquente, en particulier au niveau mondial.

Pourquoi et comment lutter ?

On ne pourra jamais stopper les attaques, mais on peut en revanche se défendre et les bloquer, évitant ainsi la consommation inutile de ressources et d’énergie. De la dissuation à l’anihilation, plusieurs moyens de protection existent.

Le webmaster : La dissuasion

D’une part, le webmaster a son rôle à jouer sur la dissuasion. En sécurisant son site, le webmaster peut « aider » le pirate (ou robot pirate) à rapidement se rendre compte qu’il s’acharne pour rien : Le site est à jour, il n’y a pas de faille de sécurité connue, aucun intérêt de continuer. Pour peu que l’attaque soit un minimum évoluée, celle-ci devrait s’estomper rapidement. En outre, cela permet surtout d’éviter d’être piraté.

Le webmaster peut également mettre en place des modules de sécurité, pour bloquer automatiquement les IP attaquantes, je pense par exemple au plugin WordFence pour WordPress, qui va (entre autres) protéger du brutefore.

Le webmaster peut aussi utiliser les outils de sécurité fournis par son hébergeur. HaiSoft en propose un certain nombre que nous allons évoquer juste après.

Enfin, un site sécurisé est un site qui ne sera pas piraté et génèrera donc une consommation électrique moindre.

Il y a donc tout à y gagner à se protéger.

L’hébergeur : Le (gros) bras armé

D’autre par l’hébergeur tel qu’HaiSoft a bien-sûr un rôle majeur à jouer dans ce combat et peut éviter de nombreuses attaques.

Chez HaiSoft, plusieurs sécurités automatiques sont mises en place. Elles filtrent les attaques, les détectent, et bloquent les IP des attaquants. Une fois l’IP bloquée, les requêtes n’atteignent plus les serveurs et nous évitons le souci.

Evidemment, l’hébergeur se doit d’utiliser du software de pointe et de régler les accès sensibles avec une grande rigueur afin d’éviter toute intrusion ou même de bloquer toute tentative d’intrusion, avec du filtrage de ports ou d’IP.

Nous avons également observé qu’un suivi manuel et fréquent est également requis pour contrer les attaques qui passeraient entre les filets des systèmes automatiques. En effet, parfois, la « charge » (utilisation des serveurs) générée par un robot pirate n’est pas suffisante pour ralentir notre serveur et déclencher une alerte de monitoring. C’est pourquoi nous avons mis en place en plus, des systèmes de monitoring en temps réel, nous permettant de vérifier régulièrement et efficacement l’utilisation des ressources de manière plus précise.

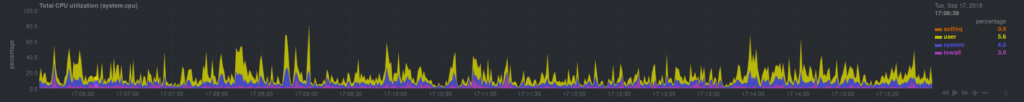

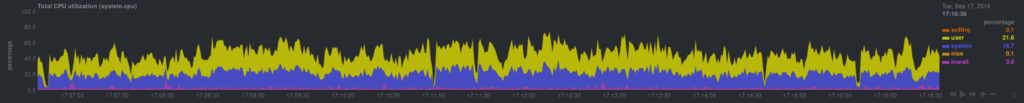

Voici un exemple : au lieu de voir des pics d’utilisation plus ou moins aléatoires (typiquement des chargements de pages), l’utilisation devient constante (chargements de page en permanence, effectués par un robot).

Grâce à ce type de graphes, nous savons donc qu’il y a une activité anormale sur le serveur et poussons les investigations pour bloquer les quelques IP attaquant des sites sur le serveur.

Les mesures prises par HaiSoft

Voici par exemple les mesures majeures nativement en place sur les hébergements mutualisés HaiSoft :

- Sécurité anti-bruteforce (Fail2ban) sur de nombreux services, y-compris le login WordPress

- Pare-feu-applicatif bloquant les requêtes dangereuses, scans de robots et tentatives de hack (et déclenchant le bannissement d’IP par Fail2Ban en cas de répétition)

- Filtrages de ports et d’IP sur les services sensibles

- WordPress Toolkit incluant des sécurités pouvant déclencher le blocage Fail2Ban ainsi que des détections anti-robots supplémentaires

- Vérification fréquente et précise de l’utilisation des ressources pour détecter les attaques, et bloquage manuel des IP attaquantes

Clients VM ou serveur dédié ? Nous proposons d’appliquer l’ensemble de ces mesures gratuitement à l’ensemble de nos clients VM et dédiés, dans le cadre du service d’infogérance inclus avec tous nos serveurs.

Bilan

Ces mesures ont permis de diviser par 3 à 4 l’utilisation des ressources CPU sur les serveurs mutualisés, donc de réduire drastiquement notre consommation électrique. En outre, cela a également permis de diminuer la charge des serveurs d’une manière gérable et ainsi d’améliorer drastiquement le temps de réponse des sites. Autant dire qu’avec le passage simultanné des serveurs en SSD, les performances sont désormais meilleures que jamais.

L’inconvénient est qu’un certain nombre de situations peuvent déclencher des faux positifs. Par exemple, si un fichier interdit à l’accès est appelé sur votre site sur chaque page, vous déclenchez une erreur sur le serveur web à chaque clic : La répétition de ces erreurs peut être prise pour une attaque, ce qui va bloquer votre IP. Cela demande donc un nouveau type de support occasionnel, mais réduit beaucoup plus fortement les demandes concernant les lenteurs.

La fréquence des piratages de sites a été réduite depuis la mise en place de ces dispositions, néanmoins, ayant beaucoup travaillé à ce que les utilisateurs passent à des versions de PHP plus récentes et mettent à jour leur scripts, il est difficile de savoir dans quelle proportion ces mesures de sécurité ont opéré.

Conclusion : Un combat forcément gagnant pour tous

L’avantage dans ce combat, c’est que tout le monde y gagne :

- Les propriétaires de sites gagnent en sécurité, en rapidité et sont moins piratés

- Les hébergeurs gagnent en consommation énergétique et observent une diminution des demandes de support

- Les ressources de notre planète sont économisées

Votre site est-il sécurisé ? Votre serveur dispose-t-il des sécurités évoquées dans cet article ? N’hésitez pas à contacter HaiSoft pour plus d’informations.